ChatGPT, das revolutionäre KI-Sprachmodell von OpenAI, hat die Art und Weise, wie wir mit Technologie interagieren, grundlegend verändert. Durch seine Fähigkeit, menschenähnliche Texte zu generieren, Fragen zu beantworten und sogar kreative Inhalte wie Geschichten oder Gedichte zu verfassen, hat es sowohl Begeisterung als auch Skepsis ausgelöst. Doch eine entscheidende Frage beschäftigt viele Nutzerinnen und Nutzer weiterhin: Wie genau ist ChatGPT im Jahr 2025 – und können wir uns auf seine Antworten verlassen?

Entwicklung und Grundlagen

Das Fundament von ChatGPT basiert auf der Transformer-Architektur, die es dem Modell ermöglicht, kontextbezogene Zusammenhänge zu erkennen und darauf basierend kohärente und plausibel klingende Antworten zu erzeugen. Seit seiner Einführung wurde ChatGPT mehrfach verbessert, insbesondere durch das Feintuning auf spezifischen Datensätzen und durch kontinuierliche Aktualisierungen des zugrundeliegenden Modells. Ziel dieser Weiterentwicklungen ist es, sowohl die Genauigkeit bei allgemeinen Fragen als auch die Fähigkeit zur Problemlösung in komplexeren Anwendungsfeldern zu erhöhen.

Neueste Forschungsergebnisse

Aktuelle Studien im Jahr 2025 konzentrieren sich vor allem auf folgende Aspekte:

- Kontextverständnis: ChatGPT soll längere und komplexere Anfragen erfassen und verarbeiten können, ohne wesentliche Informationen zu verlieren. Forschende evaluieren dabei, wie gut das Modell Texte in mehreren Abschnitten oder Unterthemen überblicken kann.

- Bias und Fairness: Trotz spezieller Trainingsverfahren können KI-Modelle Vorurteile (Bias) aus ihren Trainingsdaten übernehmen. Neue Forschungen fokussieren sich daher auf Methoden, diese Verzerrungen zu reduzieren, beispielsweise durch zusätzliche Filtermechanismen oder durch Überwachung von Modellantworten in Echtzeit.

- Multimodale Fähigkeiten: Viele Forschungsinitiativen gehen inzwischen über reine Textverarbeitung hinaus. Es wird untersucht, wie ChatGPT neben Text auch Bilder, Audios oder Videos besser verstehen oder gar erzeugen kann. Dies eröffnet potenziell ganz neue Anwendungsfelder, stellt jedoch auch höhere Anforderungen an Datengrundlage und Rechenleistung.

Genauigkeitsbenchmarks

Die Leistung von ChatGPT wird fortlaufend anhand von Benchmarks und Testdatensätzen gemessen. Diese Benchmarks bewerten unterschiedliche Bereiche, darunter Sprachverständnis, Grammatik, Kontextgenauigkeit und die Fähigkeit, konsistente Argumentationsketten zu erstellen. Im Jahr 2025 haben unabhängige Forschungsinstitute mehrere groß angelegte Vergleiche mit anderen Sprachmodellen durchgeführt, bei denen ChatGPT in den meisten Bereichen eine solide Platzierung erreichen konnte. Insbesondere wenn es um Klarheit und Struktur bei längeren Antworten geht, hat sich das Modell laut diesen Studien gegenüber seinen Vorgängerversionen deutlich verbessert.

Faktoren, die die Zuverlässigkeit beeinflussen

- Qualität und Aktualität der Trainingsdaten: Ein entscheidender Faktor für die Genauigkeit von ChatGPT sind die Daten, mit denen es trainiert wurde. Wenn Informationen über neuere Ereignisse fehlen oder wenn die Trainingsdaten veraltet sind, kann dies zu Unstimmigkeiten in den Antworten führen.

- Modellgröße und Rechenressourcen: Größere Modelle benötigen mehr Rechenkapazitäten, können jedoch oft komplexere Zusammenhänge abbilden. Ein leistungsfähigeres Modell ist in der Regel in der Lage, genauere und umfassendere Antworten zu liefern.

- Architektur-Updates und Feintuning: Regelmäßige Aktualisierungen und spezialisierte Feintuning-Schritte sind notwendig, um das Modell an neue Anforderungen anzupassen. Gleichzeitig können Änderungen die Reproduzierbarkeit beeinflussen – eine Funktion, die vor dem Update einwandfrei lief, muss nach dem Update möglicherweise erneut getestet und evaluiert werden.

- Ethische und rechtliche Rahmenbedingungen: Zur Wahrung ethischer Standards und zur Einhaltung gesetzlicher Vorgaben werden Filter und Sicherheitsmechanismen eingebaut. Diese können manchmal zu vorsichtigem Verhalten bei der Beantwortung bestimmter Themen führen, was zu inkonsistenten oder ausweichenden Antworten beitragen kann.

Praktische Anwendung und Herausforderungen

- Wirtschaft und Kundenservice: Unternehmen setzen ChatGPT zunehmend in Chatbots und virtuellen Assistenten ein, um Kundenanfragen schneller und effizienter zu beantworten. Die Herausforderung besteht darin, das Modell so zu trainieren, dass es konsistente, verlässliche Informationen liefert und dabei die Marke oder Unternehmensrichtlinien widerspiegelt.

- Bildung und Forschung: In Universitäten und Forschungseinrichtungen helfen KI-Modelle wie ChatGPT bei Literaturrecherchen und beim Verfassen wissenschaftlicher Texte. Wichtig bleibt jedoch die kritische Überprüfung der Ergebnisse durch Fachexperten, da KI-Systeme gelegentlich Fehler oder Unstimmigkeiten übersehen können.

- Kreative Bereiche: Autoren, Designer und Künstler experimentieren mit ChatGPT, um Ideen zu generieren oder erste Konzepte für Projekte zu entwerfen. Hier steht oft nicht die Faktengenauigkeit, sondern die Inspiration im Vordergrund.

Fazit: Können wir uns auf ChatGPT verlassen?

ChatGPT hat im Jahr 2025 große Fortschritte gemacht, was Genauigkeit, Kontextverständnis und die Verarbeitung komplexer Informationen angeht. Die stetige Weiterentwicklung durch umfassende Forschungsarbeiten und fortlaufende Feintuning-Prozesse steigert das Potenzial des Modells erheblich. Dennoch gilt wie bei jeder Technologie: Ein kritisches Hinterfragen von Ausgaben bleibt unverzichtbar. Ganz gleich, ob ChatGPT bei einer Recherche, im Kundenservice oder zur Inspiration eingesetzt wird – die beste Vorgehensweise ist eine gesunde Mischung aus Vertrauen in fortschrittliche KI-Technologie und menschlicher Überprüfung.

In diesem Artikel haben wir einen detaillierten Blick auf die neuesten Forschungsergebnisse, Genauigkeitsbenchmarks und Faktoren geworfen, die die Leistung von ChatGPT beeinflussen. Bei richtiger Anwendung kann dieses Sprachmodell einen großen Nutzen für zahlreiche Lebens- und Arbeitsbereiche bieten. Gleichzeitig sind technisches Feingefühl, ethische Überlegungen und kontinuierliche Qualitätskontrollen wichtige Eckpfeiler, um das Potenzial von ChatGPT verantwortungsvoll und zielführend auszuschöpfen.

Quelle: https://paperswithcode.com/sota/multi-task-language-understanding-on-mmlu

Genauigkeitsbenchmarks: Wie misst man die Leistung von ChatGPT?

Die Messung der Genauigkeit eines großen Sprachmodells (LLM) wie ChatGPT ist eine anspruchsvolle Aufgabe, die Forscherinnen und Forscher auf verschiedene Weise angehen. Mithilfe unterschiedlicher Benchmarks können sie feststellen, wie gut das Modell bei verschiedenen Arten von Aufgaben und Themenbereichen abschneidet. Im Folgenden werfen wir einen Blick auf zwei zentrale Benchmark-Tools und beleuchten die wichtigsten Faktoren, die die Genauigkeit von ChatGPT in der Praxis beeinflussen.

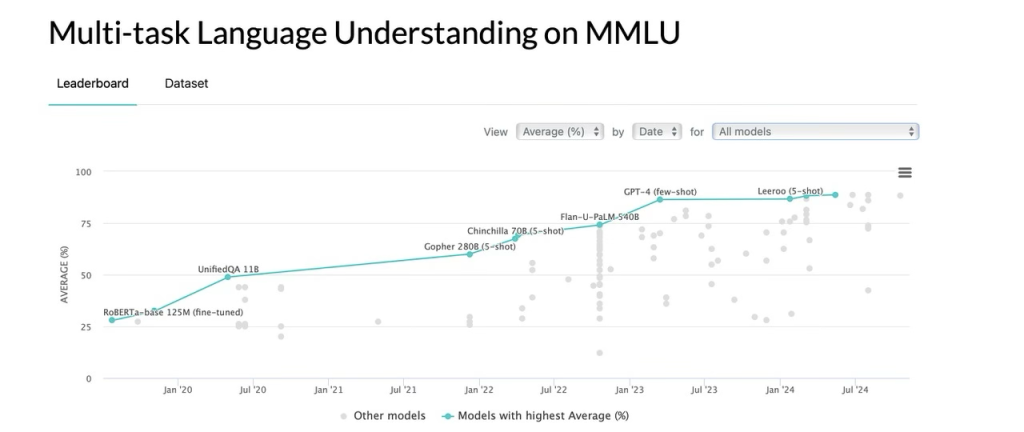

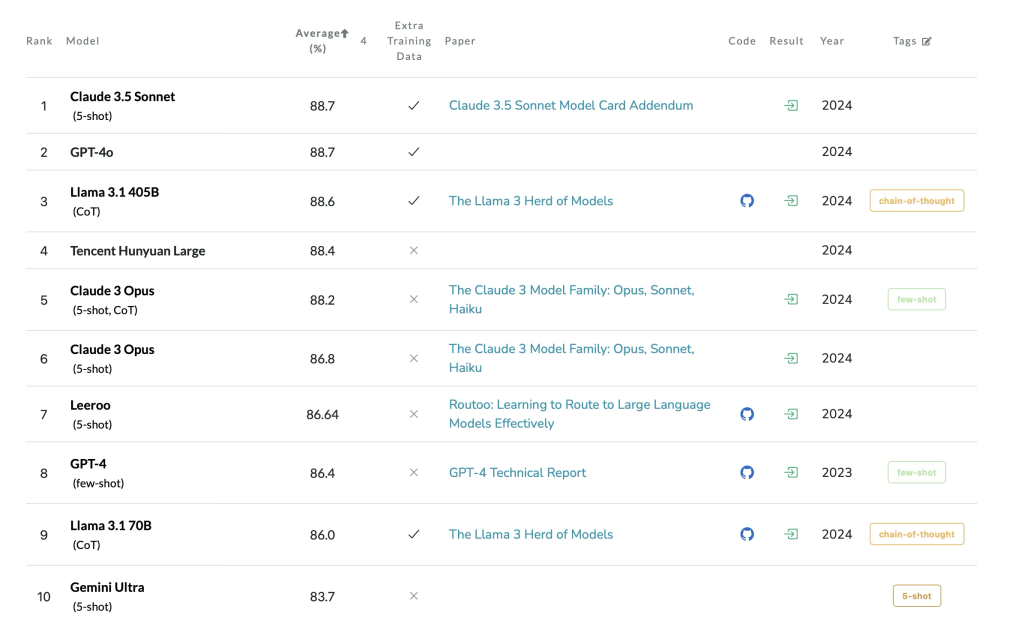

1. Massive Multitask Language Understanding (MMLU)

Der Massive Multitask Language Understanding (MMLU)-Test ist ein beliebter Standard, um die Leistungsfähigkeit von Sprachmodellen in unterschiedlichen Themenfeldern zu messen. Hierbei werden Tausende Fragen aus Bereichen wie Geschichte, Mathematik, Naturwissenschaften und vielem mehr gestellt.

-

Aktuelle Ergebnisse

Laut den neuesten Daten erreicht ChatGPT-4o, das neueste Modell von OpenAI, in MMLU-Tests eine Genauigkeitsrate von 88,7 %. Damit zählt es zu den stärksten derzeit verfügbaren Sprachmodellen und liegt nur knapp hinter Claude 3.5 Sonnet.

Ältere Modelle wie GPT-3.5 weisen hier eine deutlich geringere Genauigkeit auf, die zwischen 50 % und 80 % schwanken kann – je nach Art der Frage und Komplexität des Themas. -

Beispiel für Modellveränderungen

Eine interessante Beobachtung aus der Forschung ist, dass die Genauigkeit von GPT-4 bei der Primzahlerkennung innerhalb von nur drei Monaten von 84 % auf 51 % gesunken ist. Dieser Rückgang unterstreicht die dynamische Natur von KI-Modellen: Selbst nach einem Update oder Feintuning können sich ihre Fähigkeiten in bestimmten Bereichen verschlechtern, während sie in anderen Bereichen besser werden.

2. LMSYS Chatbot Arena (LM Arena)

Ein weiteres entscheidendes Benchmark-Tool ist die LMSYS Chatbot Arena, auch bekannt als LM Arena. Hier treten verschiedene LLMs in anonymen Duellen gegeneinander an, um ihre Reaktionsqualität, Kohärenz und Genauigkeit zu testen.

-

Aktuelle Ranking-Daten

- Gemini-Exp-1206 führt derzeit mit einem Arena-Score von 1374.

- ChatGPT-4o-latest (2024-11-20) liegt knapp dahinter mit einem Arena-Score von 1365.

- GPT-4o-2024-05-13 kommt mit einem Arena-Score von 1285 auf den dritten Platz.

Diese Ergebnisse machen deutlich, dass selbst innerhalb derselben Modellfamilie – hier GPT-4 in verschiedenen Versionen – deutliche Unterschiede in der Leistung vorkommen können. Solche Schwankungen hängen in der Regel mit Aktualisierungen, Trainingsdaten und Anpassungen des Modells zusammen.

Genauigkeit in der Praxis: Welche Faktoren beeinflussen ChatGPTs Leistung?

Obwohl Benchmarks wie MMLU und LMSYS Chatbot Arena einen wichtigen Hinweis auf die Gesamtleistung geben, spiegeln sie nicht immer Eins-zu-eins den praxisnahen Einsatz wider. Hier sind die zentralen Einflussfaktoren, die die Genauigkeit von ChatGPT im Alltag bestimmen.

-

Fachwissen

ChatGPT erbringt in Themenbereichen, für die umfangreiche und qualitativ hochwertige Trainingsdaten vorliegen, in der Regel ausgezeichnete Ergebnisse. Bei spezifischen, seltenen oder hochspezialisierten Themen kann die Genauigkeit jedoch deutlich abnehmen, da weniger Daten für das Training zur Verfügung stehen. -

Fragenkomplexität

Einfache, klar definierte Fragen werden eher korrekt beantwortet als komplexe, mehrdeutige oder mehrstufige Aufgaben. So kann es vorkommen, dass ChatGPT bei einer sehr detaillierten Anfrage Fehler macht oder nicht die erhoffte Tiefe erreicht. -

Prompt Engineering

Wie gut eine Anfrage formuliert ist, hat erheblichen Einfluss auf das Ergebnis. Prompt Engineering zielt darauf ab, Fragen so präzise wie möglich zu stellen und relevante Kontextinformationen zu liefern. Eine durchdachte Prompt-Formulierung kann die Genauigkeit der Antwort erheblich steigern. -

Sprachabhängigkeit

ChatGPT liefert die besten Ergebnisse auf Englisch, da das Modell stark auf englischsprachigen Daten beruht. In weniger verbreiteten Sprachen kann es häufiger zu Ungenauigkeiten und Missverständnissen kommen, was die Einsatzmöglichkeiten entsprechend einschränkt.

Fazit: Benchmarks und Praxis gekonnt kombinieren

Die Genauigkeit von ChatGPT lässt sich zwar durch standardisierte Tests wie MMLU und die LMSYS Chatbot Arena gut quantifizieren, dennoch sollten Anwenderinnen und Anwender diese Zahlen nicht isoliert betrachten. Denn in der realen Anwendung spielen weitere Faktoren wie die Komplexität der Frage, die Verfügbarkeit von Trainingsdaten und die Sprachversion eine wichtige Rolle.

Um das volle Potenzial von ChatGPT zu nutzen, empfiehlt es sich daher:

- Klare und gut strukturierte Prompts zu formulieren,

- Kontinuierlich Updates und neue Forschungsergebnisse zu beobachten,

- Spezialthemen durch manuelle Prüfung oder ergänzende Ressourcen abzusichern und

- Bei Bedarf Alternativen zu testen, um die jeweilige Fragestellung möglichst zuverlässig zu beantworten.

Auf diese Weise profitieren Unternehmen, Entwickler und Forschende gleichermaßen von den Stärken eines fortschrittlichen KI-Sprachmodells wie ChatGPT, ohne dabei die Grenzen und Potenzial für Fehlentwicklungen aus den Augen zu verlieren.

https://paperswithcode.com/sota/multi-task-language-understanding-on-mmlu

Modellversion: Neuere Modelle (z. B. GPT-4o) haben höhere Genauigkeitsraten als ältere Versionen wie GPT-3.5

Im Laufe der letzten Jahre haben sich KI-basierte Sprachmodelle rasant weiterentwickelt. Besonders deutlich wird dies am Beispiel von Modellen wie GPT-3.5 und seinen Nachfolgern wie GPT-4 oder GPT-4o. Bei älteren Modellen können bestimmte Fehlerquellen – etwa fehlende Kontextverarbeitung oder unzureichend trainierte Parameterräume – häufiger auftreten. Die neueren Modellversionen setzen dagegen auf eine verfeinerte Architektur und umfangreichere Trainingsdaten. Dadurch steigen nicht nur die Genauigkeitsraten, sondern auch die Fähigkeit, komplexere Zusammenhänge besser zu erfassen.

Was bedeutet „höhere Genauigkeitsrate“?

Eine höhere Genauigkeitsrate bezieht sich auf die korrekte Beantwortung von Fragen, die Qualität von Textausgaben und die Reduktion von offensichtlichen Fehlern. Während GPT-3.5 in vielen Anwendungsfällen bereits zuverlässige Ergebnisse liefern konnte, zeigen Untersuchungen, dass GPT-4 und speziell GPT-4o bei anspruchsvollen Themen (wie wissenschaftlichen Abhandlungen oder medizinischen Fragestellungen) meist präzisere Antworten geben.

Halluzinationen und Fehlinformationen: Ein anhaltendes Problem?

Was sind Halluzinationen in KI-Modellen?

Ein zentrales Problem, das trotz aller Fortschritte bestehen bleibt, ist das Phänomen der „Halluzinationen“: Dabei erzeugt das KI-Modell falsche oder unsinnige Informationen, die jedoch in einem scheinbar selbstbewussten und überzeugenden Ton dargeboten werden. Für die Nutzenden ist es nicht immer sofort erkennbar, dass es sich um unkorrekte Inhalte handelt.

Aktuelle Studienergebnisse zu Halluzinationen

Eine aktuelle Untersuchung hat gezeigt, dass GPT-3.5 in 39,6 % der Fälle wissenschaftliche Referenzen halluzinierte. Das bedeutet, dass das Modell Quellenangaben nannte, die entweder nicht existieren oder mit dem Inhalt nicht übereinstimmen. Bei GPT-4 wurde diese Rate zwar auf 28,6 % reduziert, dennoch treten solche Fehler weiterhin auf. Die scheinbar willkürliche Generierung von Quellen kann in kritischen Anwendungsbereichen zu erheblichen Problemen führen, da falsche Daten für Entscheidungen oder weitere Recherchen herangezogen werden könnten.

Warum gibt ChatGPT selten Unsicherheit an?

Ein weiteres Problem besteht darin, dass ChatGPT in den seltensten Fällen zugibt, wenn es sich unsicher ist. Stattdessen produziert es oft eine plausible, aber im Kern möglicherweise falsche Antwort. Dadurch kann bei den Nutzenden der Eindruck entstehen, es handle sich um eine gesicherte Aussage. In Bereichen, in denen Fehler gravierende Folgen haben können – wie Medizin, Recht oder Finanzberatung – ist dieser Aspekt besonders kritisch.

Die Rolle der menschlichen Überprüfung

Warum ist menschliche Überprüfung unverzichtbar?

Obwohl ChatGPT und ähnliche Modelle in vielen Situationen beeindruckende Ergebnisse liefern, dürfen sie nicht als unfehlbar betrachtet werden. Selbst modernste Modelle können irren oder unvollständige Informationen wiedergeben. Besonders in sensiblen Bereichen, in denen Fehlentscheidungen weitreichende Konsequenzen haben können, ist eine zusätzliche Validierung durch Fachleute oder durch seriöse Quellen unerlässlich.

Praxisbeispiele für Schwächen

-

Orthopädische Erkrankungen

Bei orthopädischen Fragestellungen liefert ChatGPT in der Regel ordentliche Grundinformationen. Trotzdem reicht die Detailtiefe nicht an spezialisierte Fachportale (z. B. AAOS OrthoInfo-Website) heran, deren Inhalte von Experten kuratiert werden. -

Medizinische Zulassungsprüfungen

Obwohl ChatGPT in Simulationsprüfungen im medizinischen Bereich teilweise besteht, offenbaren sich insbesondere bei komplexen Aufgaben wie Differentialdiagnosen Schwächen. Fehlende Kontextinformationen oder Unsicherheiten im Modell können zu Fehleinschätzungen führen, die für medizinisches Personal ein erhebliches Risiko darstellen könnten.

Wie kann man die Genauigkeit von ChatGPT verbessern?

OpenAI investiert fortlaufend in die Weiterentwicklung von ChatGPT. Doch auch auf Seiten der Nutzerinnen und Nutzer gibt es effektive Methoden, um die Qualität und Zuverlässigkeit der generierten Inhalte zu steigern.

-

Präzisere Prompts formulieren

Ein wesentlicher Faktor für die Genauigkeit ist die Fragestellung selbst. Je klarer und kontextreicher eine Frage formuliert wird, desto geringer ist das Risiko von Fehlinterpretationen. Dies umfasst das Angeben von zusätzlichen Informationen, Hintergründen oder konkretisierten Fragestellungen. -

Websuche aktivieren

Neuere Modellversionen wie GPT-4o bieten inzwischen die Möglichkeit, auf Websuchen zuzugreifen und damit Echtzeitinformationen einzubeziehen. Dadurch können veraltete oder unvollständige Daten reduziert werden, wenn das Modell beispielsweise aktuelle Studien oder Nachrichteninhalte recherchieren darf. -

Kritische Informationen gegenprüfen

Besonders bei sensiblen Themen wie Gesundheit, Recht oder Finanzen gilt: Die von ChatGPT bereitgestellten Informationen sollten mit alternativen Quellen oder einschlägigen Fachartikeln abgeglichen werden. So lassen sich eventuell enthaltene Fehler oder Unklarheiten frühzeitig erkennen. -

Vergleich mit anderen LLMs

Es existieren mehrere KI-Sprachmodelle unterschiedlicher Anbieter. Ein Abgleich der Ergebnisse verschiedener Modelle kann bei Unsicherheiten helfen, Widersprüche aufzudecken. Finden sich erhebliche Diskrepanzen, ist eine zusätzliche Prüfung durch menschliche Experten ratsam.

Fazit: Ist ChatGPT 2025 verlässlich?

ChatGPT hat sich in den letzten Jahren enorm weiterentwickelt. Die Genauigkeitswerte sind gestiegen, die Formulierungskompetenz hat zugenommen und die Fähigkeit, komplexe Themen zusammenzufassen, verbessert sich stetig. Trotzdem muss stets bedacht werden, dass jedes KI-Modell fehleranfällig ist und Blindvertrauen in generierte Inhalte riskant sein kann.

Nutzende sollten die potenziellen Fehlerquellen kennen und bei kritischen Fragen oder Entscheidungen eine zweite Meinung einholen. Mit den oben genannten Strategien – von der präzisen Eingabe der Prompts bis hin zur systematischen Gegenprüfung von Ergebnissen – lassen sich viele Fehler bereits im Vorfeld minimieren. Gleichzeitig verspricht die rasante Entwicklung, dass zukünftige Modellversionen noch zuverlässiger und leistungsfähiger werden. Doch bis dahin bleibt die menschliche Überprüfung ein unverzichtbares Korrektiv, um Fehlinformationen rechtzeitig zu erkennen und falsche Entscheidungen zu vermeiden.

Schreiben Sie einen Kommentar